22 nov. 2019

Construyendo un NAS profesional de 72TB

Configuración e instalación de un servidor HPE ProLiant DL380

Durante los últimos años he estado moviendo mis datos y trabajo desde computadoras locales (principalmente laptops) a la nube. La computación en la nube se realiza mediante servidores en un centro de datos, computadoras potentes que hacen el trabajo duro. A medida que mi empresa creció, necesité más capacidad. ¡Era hora de agregarle potencia a mi nube!

Computación en la Nube

Durante los últimos años, "La Nube" se ha comercializado como un fenómeno mágico que resuelve muchos problemas empresariales. Sin embargo, desde una perspectiva técnica, no es más que concentrar la potencia informática en centros de datos en lugar de en tu escritorio.

Las principales ventajas son que puedes acceder a recursos informáticos (extremadamente) potentes que se escalan a medida que crece tu carga de trabajo. Imagina tu escritorio: solo hay un espacio limitado para una computadora. En contraste, un centro de datos es físicamente mucho más grande y permite que muchas computadoras servidor diferentes trabajen en conjunto, ofreciendo más capacidad.

Además de la escalabilidad, el centro de datos es un entorno mucho mejor para las computadoras que tu oficina. Piensa en cosas simples como el polvo, derramar café, cortes de energía y las diferencias de temperatura y humedad. Y si eres como yo, commuting by bike, es bueno que tus datos estén almacenados de forma segura en un centro de datos en lugar de en una computadora portátil en tu mochila (expuesta a golpes, clima, etc.).

Servidor HPE DL380

Mi empresa utiliza servidores HPE ya que tienen un historial probado de confiabilidad y ofrecen muchas características de diseño inteligentes que permiten un fácil mantenimiento. En muchos sentidos, están diseñados para facilitar la vida de un ingeniero de sistemas.

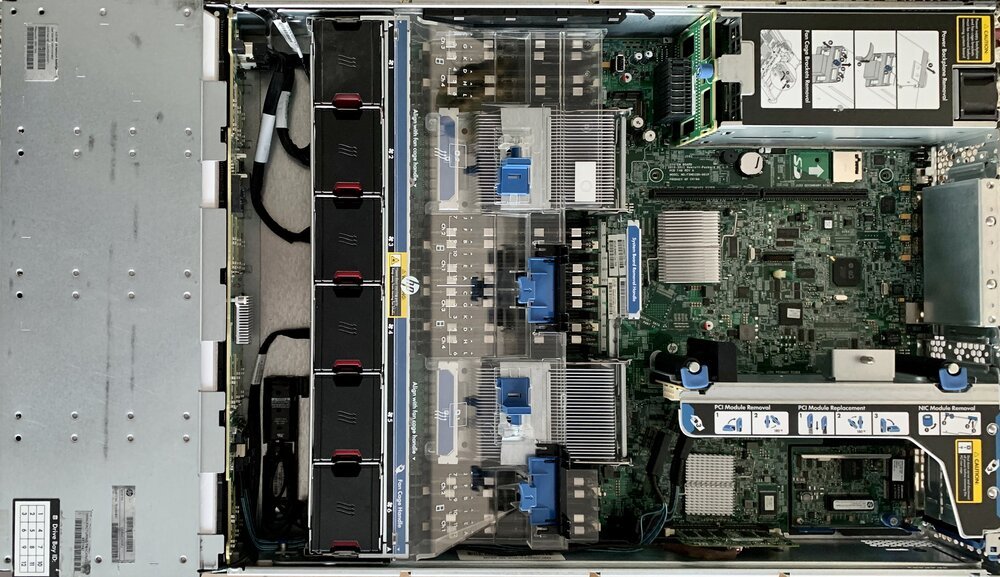

En la imagen de arriba verás el servidor HPE DL380 por dentro. Déjame explicarte sus entrañas de izquierda a derecha:

- Bahía de unidades: la carcasa metálica gris es donde residen los discos duros o SSD. Están en la parte frontal del servidor cuando está montado dentro de un rack, lo que permite un fácil acceso para agregar/reemplazar unidades; generalmente sin necesidad de herramientas.

- Conjunto de ventiladores: las 6 cajas negras son ventiladores, que aspiran aire frío de la izquierda y lo empujan hacia la derecha. Cada ventilador se monitoriza individualmente. Si un ventilador falla, otros asumirán su carga soplando más rápido. Cada ventilador es muy fácil de reemplazar, nuevamente sin necesidad de herramientas.

- Procesadores y memoria: En el centro, detrás del plástico transparente (túnel de enfriamiento) están los dos procesadores y 16 bancos de memoria. Puedes reconocer los procesadores por su disipador de calor metálico. Están rodeados de (muchos) bancos de memoria, y su ubicación física muy cerca de los procesadores permite anchos de banda muy altos. Están justo al lado del conjunto de ventiladores, maximizando la envoltura térmica.

- Unidades de fuente de alimentación: En la parte superior derecha están las dos unidades de fuente de alimentación. Trabajan en conjunto, dividiendo la carga eléctrica entre ellas. Si una falla, la otra es capaz de alimentar todo el servidor. Esto proporciona redundancia, ya que te permite conectar el servidor desde múltiples fuentes de alimentación (diferentes) en el centro de datos.

- Placa del sistema: los chips verdes que verás en el centro a la derecha comprenden la placa principal del sistema o lógica. Contiene varios componentes que conforman el servidor. Notarás cosas como la batería (del reloj), el lector de tarjetas SD y el chip iLO. Este último es el sistema 'lights out' integrado de HPE, una computadora dentro de una computadora, que permite a los ingenieros verificar de forma remota las entrañas del servidor.

- Controlador RAID: En la parte inferior derecha está el controlador RAID, donde RAID significa "matriz redundante de discos independientes". Conecta y organiza las unidades físicas en la bahía de unidades. Es capaz de dividir los datos en diferentes discos, lo que permite cierta redundancia en caso de fallo de la unidad.

Instalación de un sistema operativo en el servidor

Al igual que tu computadora de escritorio o portátil, el servidor también necesita un sistema operativo. Para los servidores, es común usar un tipo especial de sistema operativo que permite instalar otros sistemas operativos de forma remota. El sistema operativo principal te permite dividir la capacidad en múltiples servidores virtuales, esto se llama un sistema operativo hipervisor.

La ventaja de usar múltiples servidores virtuales es que puedes transferir cargas de trabajo entre máquinas físicas más fácilmente sin la necesidad de reinstalar el software. Los servidores virtuales son genéricos y capaces de ejecutarse en diferentes tipos de hardware. Esto permite la escalabilidad y la redundancia si utilizas múltiples servidores físicos en combinación con múltiples servidores virtuales.

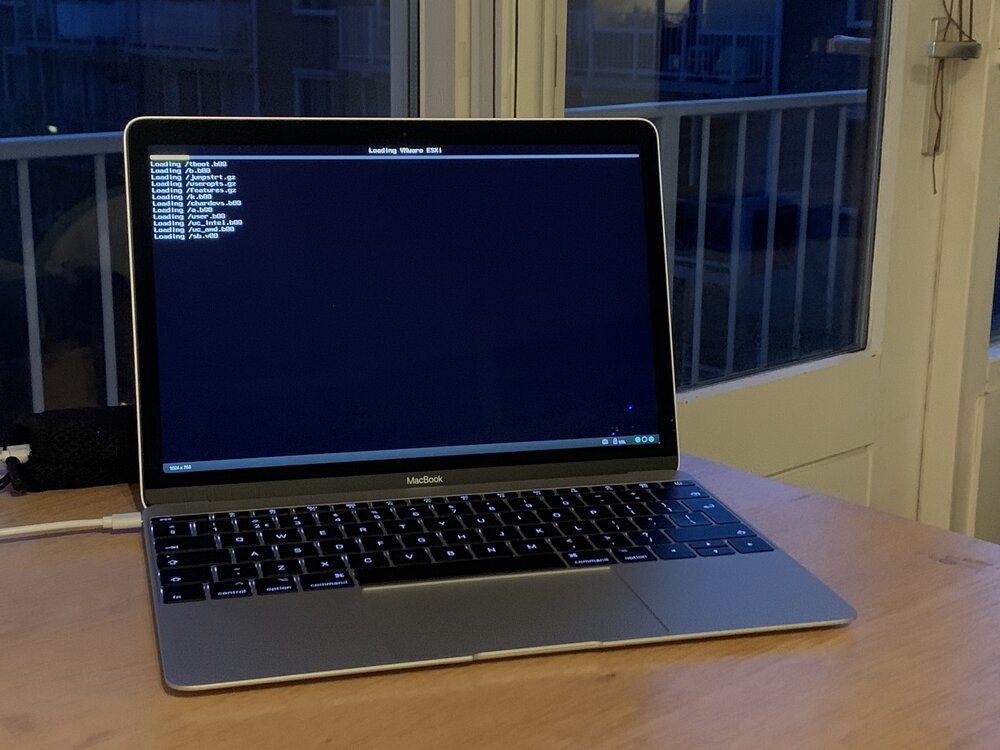

Instalar el sistema operativo funciona un poco diferente a tu computadora de oficina promedio. El servidor no tiene unidad de CD/DVD para permitir la instalación desde medios físicos. En su lugar, utilizo una red local para servir los archivos de instalación al servidor. Esto se hace usando mi computadora portátil ThinkPad X1 ejecutando un servidor web. Configuré el servidor HP para conectarse a esta computadora portátil como opción de arranque.

El MacBook está conectado al servidor a través del iLO de HPE. Le permite actuar como monitor y teclado. Esto hace posible controlar la instalación desde mi escritorio (en lugar de estar de pie junto al ruidoso servidor).

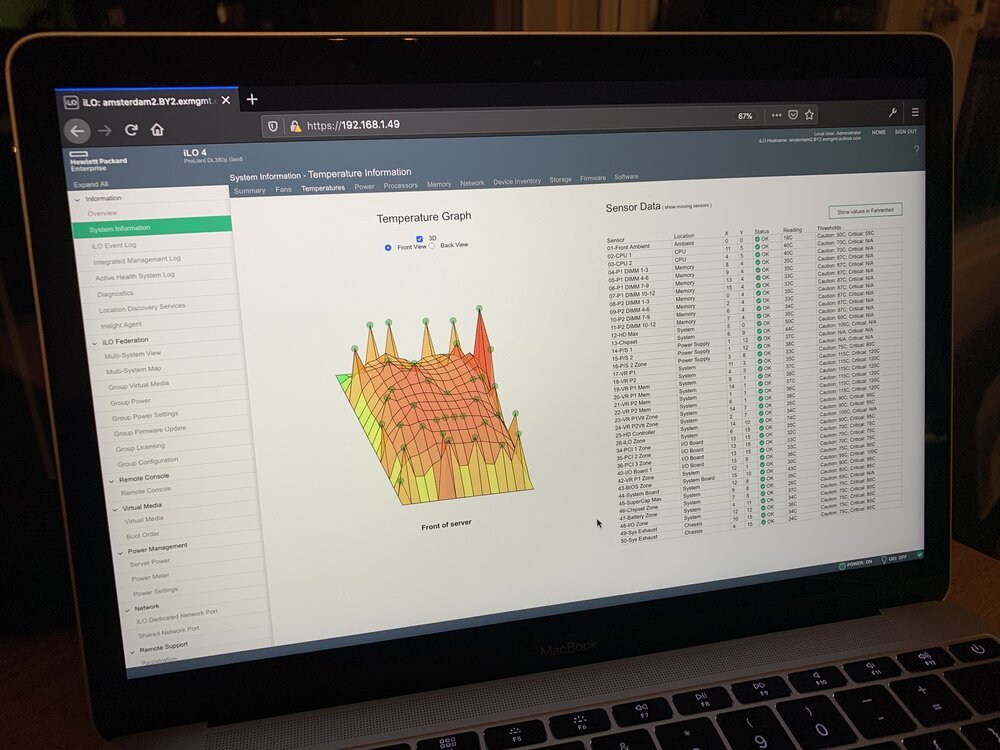

A través de iLO es posible ver todos los componentes individuales del servidor. Permite a los ingenieros verificar el estado físico del servidor, ver cómo está funcionando.

Llevarlo al centro de datos

Después de instalar el sistema operativo principal, el servidor debe colocarse en el centro de datos. En Ámsterdam hay muchos centros de datos diferentes. Mi empresa tiene varios servidores en diferentes ubicaciones, lo que limita el riesgo de pérdida de datos en caso de incendio o desastre local. Llevar el servidor al centro de datos es tan simple como concertar una cita con el centro de operaciones de red, firmar algunos contratos y subirse al coche.

Para permitir una fácil instalación en el centro de datos, preconfiguré los ajustes de red para que coincidan con los del centro de datos. Si todo funciona bien, esto permite "conectar y usar" el servidor. ¡Lo hizo, hurra!

Una vez que el servidor está en funcionamiento, puedes conectarte a él de forma remota. Esto te permite utilizarlo como una parte real de "la nube", aprovechando su potencia informática a distancia.

Conclusión

La nube está impulsada por las numerosas computadoras servidor dentro de los centros de datos. Dependiendo de tus necesidades, puedes alquilar algo de capacidad a otros o instalar máquinas físicas tú mismo.

Por varias razones, elijo operar mis propias máquinas físicas, maximizando el rendimiento y el control. La administración de servidores (tanto físicos como virtuales) se ha convertido en una especie de arte perdido, aunque crítico para el internet actual impulsado por la nube.

Descarga

Si te gusta leer sin conexión, este artículo está disponible para su descarga:

Traducciones

Este artículo está disponible en los siguientes idiomas:

RSS / Atom

Suscríbete a uno de los feeds para mantenerte al día. Los feeds contienen las publicaciones completas: