22 Nov. 2019

Einen professionellen 72-TB-NAS bauen

Konfiguration und Installation eines HPE ProLiant DL380 Servers

In den letzten Jahren habe ich meine Daten und meine Arbeit von lokalen Computern (hauptsächlich Laptops) in die Cloud verlagert. Cloud Computing wird von Servern in einem Rechenzentrum erledigt, leistungsstarken Computern, die die harte Arbeit übernehmen. Als mein Unternehmen wuchs, brauchte ich mehr Kapazität. Es war an der Zeit, meiner Cloud mehr Leistung hinzuzufügen!

Cloud Computing

In den letzten Jahren wurde "Die Cloud" als ein magisches Phänomen vermarktet, das viele Geschäftsprobleme löst. Aus technischer Sicht ist es jedoch nichts anderes als die Konzentration von Rechenleistung in Rechenzentren anstatt auf Ihrem Schreibtisch.

Die Hauptvorteile liegen darin, dass Sie auf (extrem) leistungsstarke Rechenressourcen zugreifen können, die mit zunehmender Arbeitslast skalieren. Stellen Sie sich Ihren Schreibtisch vor: Es gibt nur so viel Platz für einen Computer. Im Gegensatz dazu ist ein Rechenzentrum physisch viel größer und ermöglicht es vielen verschiedenen Servercomputern, zusammenzuarbeiten und mehr Kapazität zu bieten.

Zusätzlich zur Skalierbarkeit ist das Rechenzentrum eine viel bessere Umgebung für Computer als Ihr Büro. Denken Sie an einfache Dinge wie Staub, verschütteten Kaffee, Stromausfälle und Unterschiede in Temperatur und Luftfeuchtigkeit. Und wenn Sie wie ich sind, commuting by bike, ist es gut, dass Ihre Daten sicher in einem Rechenzentrum gespeichert sind, anstatt auf einem Laptop in Ihrem Rucksack (Stößen, Wetter usw. ausgesetzt).

HPE DL380 Server

Mein Unternehmen verwendet HPE Server, da diese eine nachgewiesene Zuverlässigkeit aufweisen und viele intelligente Designmerkmale bieten, die eine einfache Wartung ermöglichen. In vielerlei Hinsicht sind sie so konzipiert, dass sie das Leben eines Systemingenieurs einfacher machen.

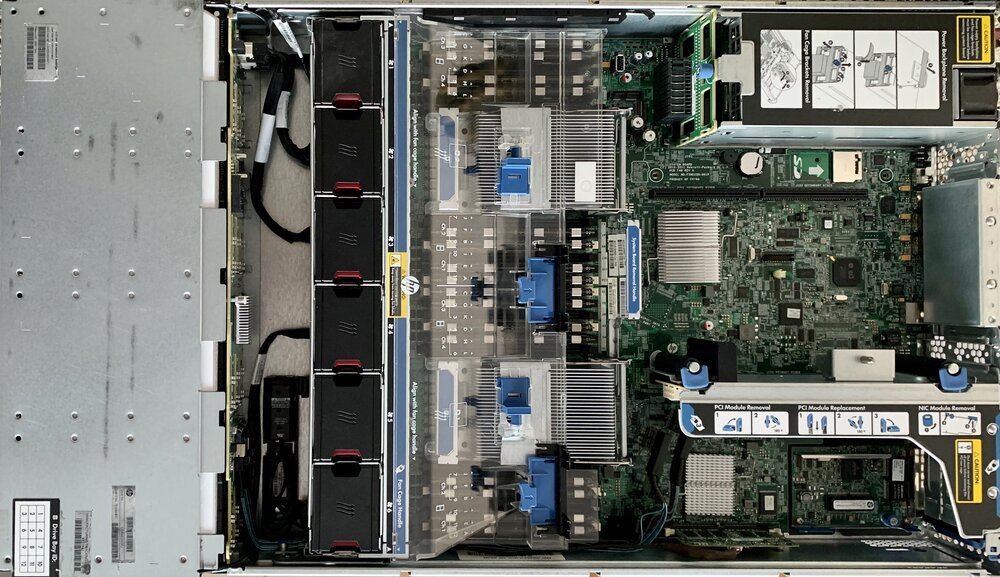

Auf dem Bild oben sehen Sie den HPE DL380 Server von innen. Lassen Sie mich seine Innereien von links nach rechts erklären:

- Laufwerksschacht: Das graue Metallgehäuse beherbergt die Festplatten oder SSDs. Sie befinden sich an der Vorderseite des Servers, wenn dieser in einem Rack montiert ist, was einen einfachen Zugriff zum Hinzufügen/Austauschen von Laufwerken ermöglicht; normalerweise ohne Werkzeug.

- Lüftereinheit: Die 6 schwarzen Kästen sind Lüfter, die kühle Luft von links ansaugen und nach rechts drücken. Jeder Lüfter wird einzeln überwacht. Wenn ein Lüfter ausfällt, übernehmen andere seine Last, indem sie schneller blasen. Jeder Lüfter ist sehr einfach auszutauschen, wiederum ohne Werkzeug.

- Prozessoren und Speicher: In der Mitte, hinter dem transparenten Kunststoff (Kühltunnel), befinden sich die beiden Prozessoren und 16 Speicherbänke. Sie erkennen die Prozessoren an ihrem metallenen Kühlkörper. Sie sind von (vielen) Speicherbänken umgeben, deren physische Nähe zu den Prozessoren sehr hohe Bandbreiten ermöglicht. Sie befinden sich direkt neben der Lüftereinheit, wodurch die thermische Hülle maximiert wird.

- Netzteile: Oben rechts befinden sich die beiden Netzteile. Sie arbeiten zusammen und teilen die elektrische Last untereinander auf. Wenn eines ausfällt, kann das andere den gesamten Server versorgen. Dies bietet Redundanz, da Sie den Server an mehrere (verschiedene) Stromquellen im Rechenzentrum anschließen können.

- Systemplatine: Die grünen Chips, die Sie in der Mitte rechts sehen, bilden das Hauptsystem bzw. die Hauptplatine. Sie enthält verschiedene Komponenten, aus denen der Server besteht. Sie werden Dinge wie die (Uhr-)Batterie, den SD-Kartenleser und den iLO-Chip bemerken. Letzterer ist das integrierte "Lights-out"-System von HPE, ein Computer im Computer, der es Ingenieuren ermöglicht, die Innereien des Servers fernzusteuern.

- RAID-Controller: Unten rechts befindet sich der RAID-Controller, wobei RAID für "Redundant Array of Independent Disks" steht. Er verbindet und organisiert die physischen Laufwerke im Laufwerksschacht. Er ist in der Lage, Daten auf verschiedene Festplatten zu verteilen, was eine gewisse Redundanz im Falle eines Festplattenausfalls ermöglicht.

Installation eines Betriebssystems auf dem Server

Genau wie Ihr Desktop- oder Laptop-Computer benötigt auch der Server ein Betriebssystem. Für Server ist es üblich, eine spezielle Art von Betriebssystem zu verwenden, die es ermöglicht, andere Betriebssysteme remote zu installieren. Das Hauptbetriebssystem ermöglicht es Ihnen, die Kapazität in mehrere virtuelle Server aufzuteilen, dies wird als Hypervisor-Betriebssystem bezeichnet.

Der Vorteil der Verwendung mehrerer virtueller Server besteht darin, dass Sie Arbeitslasten einfacher zwischen physischen Maschinen übertragen können, ohne Software neu installieren zu müssen. Die virtuellen Server sind generisch und können auf verschiedenen Hardware-Typen ausgeführt werden. Dies ermöglicht Skalierbarkeit und Redundanz, wenn Sie mehrere physische Server in Kombination mit mehreren virtuellen Servern verwenden.

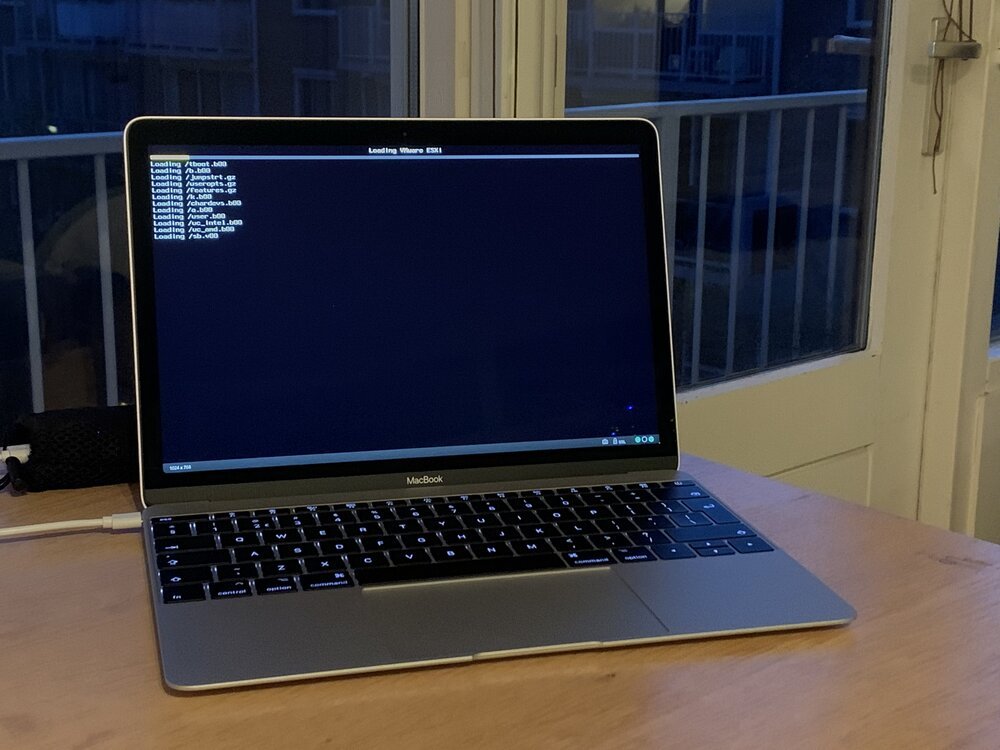

Die Installation des Betriebssystems funktioniert etwas anders als bei einem durchschnittlichen Bürocomputer. Der Server verfügt über kein CD-/DVD-Laufwerk, um die Installation von physischen Medien zu ermöglichen. Stattdessen verwende ich ein lokales Netzwerk, um die Installationsdateien für den Server bereitzustellen. Dies geschieht mit meinem ThinkPad X1 Laptop, auf dem ein Webserver läuft. Ich habe den HP Server so konfiguriert, dass er sich mit diesem Laptop als Bootoption verbindet.

Das MacBook ist über HPEs iLO mit dem Server verbunden. Es ermöglicht ihm, als Monitor und Tastatur zu fungieren. Dies ermöglicht es, die Installation von meinem Schreibtisch aus zu steuern (anstatt neben dem lauten Server zu stehen).

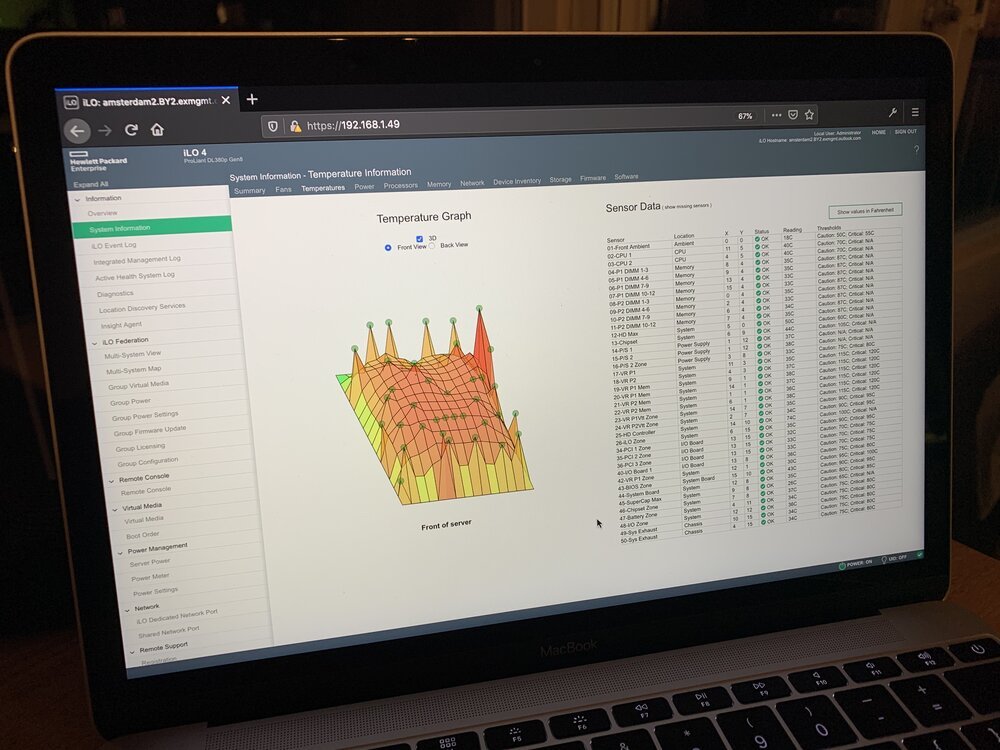

Über iLO ist es möglich, alle einzelnen Komponenten des Servers zu sehen. Es ermöglicht Ingenieuren, den physischen Zustand des Servers zu überprüfen und zu sehen, wie es ihm geht.

Transport ins Rechenzentrum

Nachdem das Hauptbetriebssystem installiert ist, muss der Server im Rechenzentrum platziert werden. In Amsterdam gibt es viele verschiedene Rechenzentren. Mein Unternehmen hat mehrere Server an verschiedenen Standorten, wodurch das Risiko von Datenverlust im Falle eines lokalen Brandes oder einer Katastrophe begrenzt wird. Den Server ins Rechenzentrum zu bringen, ist so einfach wie einen Termin mit dem Network Operation Center zu vereinbaren, ein paar Verträge zu unterschreiben und ins Auto zu springen.

Um eine einfache Installation im Rechenzentrum zu ermöglichen, habe ich die Netzwerkeinstellungen so vorkonfiguriert, dass sie mit denen des Rechenzentrums übereinstimmen. Wenn alles gut funktioniert, ermöglicht dies "Plug and Play" des Servers. Es hat funktioniert, hurra!

Sobald der Server in Betrieb ist, können Sie sich remote mit ihm verbinden. Dies ermöglicht es Ihnen, ihn als echten Teil "der Cloud" zu nutzen und seine Rechenleistung aus der Ferne anzuzapfen.

Schlussfolgerung

Die Cloud wird von den vielen Servercomputern in Rechenzentren betrieben. Je nach Bedarf können Sie entweder Kapazitäten von anderen mieten oder selbst physische Maschinen installieren.

Aus verschiedenen Gründen habe ich mich entschieden, meine eigenen physischen Maschinen zu betreiben, um Leistung und Kontrolle zu maximieren. Die Verwaltung von Servern (sowohl physisch als auch virtuell) ist zu einer etwas verlorenen Kunst geworden, wenn auch zu einer entscheidenden für das heutige Cloud-basierte Internet.

Download

Wenn Sie gerne offline lesen, steht dieser Artikel zum Download bereit:

Übersetzungen

Dieser Artikel ist in den folgenden Sprachen verfügbar:

RSS / Atom

Abonnieren Sie einen der Feeds, um auf dem Laufenden zu bleiben. Die Feeds enthalten die vollständigen Beiträge: